درباره محمدرضا معبودیان

این نویسنده هنوز اطلاعاتی درباره خود ثبت نکرده است.

محمدرضا معبودیان تا کنون 65 مطلب مفید در سایت ثبت کرده است.

مطالب توسط

وبینار «قابلیت های داده محور در سازمانها» برگزار شد.

1400/04/09 در اخبار /توسط محمدرضا معبودیانپروژه داده محوری، ماندگار است که در کنار دستاوردهایش، قابلیت تحلیلی برای سازمان ایجاد کند!.

در این نگاه تا اطلاعات دقیق و کافی پیرامون یک مسئله وجود نداشته باشد، تصمیم قطعی گرفته نمیشود.

در وبینار قابلیت های داده محوری، به موارد زیر پرداخته شد.

در سازمان های داده محور، تصمیمات راهبردی و استراتژیک بر اساس تحلیل داده در اکوسیستم داده ای خود، اتخاذ می شود. (در اکثر مواقع).

اینکه پرسنل، کارشناسان و مدیران سازمان ها، بتوانند با یک «زبان داده محوری» داشته باشند.جهت ادراک

- عملیات ها

- تجارب

- تحلیل ها

- تفسیرها و نتیجه گیریها

- تصمیم سازی ها و تصمیم گیری ها

با هم ارتباط برقرار کنند را «سواد داده ای» آن سازمان گویند.

هدف نهایی در Data Driven، استفاده از تجزیه و تحلیل داده های مرتیط توسط مدیران و کارکنان بعنوان بخشی طبیعی و مرسوم از روند کارهای روزانه آنها می باشد. این بدان معنی است که پیشرفت در یک فعالیت، بیشتر از اینکه توسط دریافت درونی و تجربه شخصی کامل شود، توسط تحلیل داده کامل گردد.

وبینار «قابلیت های داده محور در سازمانها» با حضور بیش از یکصد مدیر و کارشناس حوزه دیتا توسط تیم فرابر برگزار شد. در این وبینار با تمرکز بر:

- قابلیت ایجاد و مدیریت پلتفرم داده

- قابلیت ایجاد و مدیریت تیم تحلیل داده

- قابلیت تعریف و مدیریت پروژه های داده ای

- قابلیت استفاده از هوش مصنوعی

- قابلیت تشکیل سازمان داده محور

- قابلیت ایجاد نظام حکمرانی و مدیریت داده

و همچنین مواردی همچون «پروژه های بهبود سریع»، «پروژه های حل مسئله واکنش گرا»، «سازمان داده محور»، «سواد داده»، «تصمیم سازی و تصمیم گیری در این سازمان ها» و «سطوح بلوغ در این سازمان ها» زمینه سازی برگزاری سلسله وبینارهای حوزه Data Driven آغاز شد.

تحلیل داده چیست؟

1400/03/29 در مقاله /توسط محمدرضا معبودیانتحلیل داده به مجموعه فرآیندهایی جهت:

- ارزیابی

- صحت سنجی

- انتقال داده ها

- پاکسازی

- یکپارچه سازی

- تجمیع و تلفیق داده ها

- مدلسازی دادهها

جهت کشف دانش و بینش ارزشمند، برای تصمیمگیری در کسبوکار اطلاق می شود.هدف از تحلیل دادهها، استخراج اطلاعات مفید از دادهها، و بهبود فرآیندهای تصمیمگیری و خلق ارزش های جدید، می باشد. تصمیمگیریهای گذشته نگر و آینده نگر، توصیفی و تجویزی، نمونه هایی دیگر از تحلیل دادهها هستند.

امروزه با گسترش استفاده از زبان پایتون، شاهد افزایش رویکردهای تحلیلی در سطح سازمانی هستیم. اکثر سازمانهای داده محور از انواع مختلف الگوریتم های:

- داده کاوی

- یادگیری ماشین

- یادگیری عمیق

- تحلیل کلان داده

در تصمیم گیری ها، ایجاد دانش های جدید و ایجاد مزیت های رقابتی جدید، بهره می برند. این نتایج را می توان در پیش بینی آینده و ترندها، تخمین ها، توصیه گری های عملیاتی و محاسبات داینامیک در کسب و کار استفاده کرد.

اغلب برای تحلیل داده ها، نیاز به استقرار انبار داده، دریاچه داده، پلتفرم ذخیر سازی داده، پلتفرم های یکپارچه رویکردهای تحلیلی(Analytics) می باشد. تیم داده سازمان، با توجه به پتانسیل های داده ای سازمان، بودجه ها و امکانات، با برون سپاری یا درون سپاری، نظام داده محوری در سازمان را توسعه می دهند. البته مسئولیت تیم داده سازمان، افزایش سواد داده ای کارکنان، افزایش فرهنگ استفاده از داده ها، و مدیریت تکنولوژی در حوزه داده نیز خواهد بود. همچنین توسعه تصمیم سازی داده محور، هوشمندسازی فرآیندهای عملیاتی نیز در دستور کار، تیم داده خواهد بود.

هوش تجاری و تحلیل داده ها:

امروزه سامانه های هوش تجاری با هدف تجمیع و تحلیل داده ها بسیار مورد توجه قرار گرفته اند. هرچند سامانه های BI بیشتر گذشته نگر می باشند، ولی در رهیافت های جدید از پلتفرم های تحلیلی و پیش گویانه هم در کنار آنها استفاده می شود. در اغلب موارد سامانه های هوشمندی کسب و کار، با سامانه های پردازش کلان داده و پردازش جریانی داده ها، نیز در ارتباط هستند. همچنین حوزه فعالیت سامان های BI، از داده های سازمانی فراتر رفته و تحلیل داده های شبکه های اجتماعی و مالتی مدیا را نیز در برگرفته است. تا آنجا که مفاهیمی همچون Social-BI نیز صنعت نرم افزار جایگاه پیدا نموده اند.

تحلیل های آماری:

تحلیل آماری، به مطالعه، جمع آوری، تجزیه و تحلیل، تفسیر، ارائه و سازماندهی داده ها می پردازد. از آمارهای توصیفی و آمارهای استنباطی، جهت تحلیلگری و تولید دانش بسیار استفاده می شود. تا جایی که Statistical Learning یکی از مراحل مهم در تحلیل داده ها شناخته می شود. در پایتون می توان از انواع کتابخانه ها، برای اینگونه تحلیل ها استفاده کرد.

داده کاوی:

داده کاوی، روش تحلیل داده برای کشف الگوهای موجود در مجموعه های بزرگ داده با استفاده از روش های آماری، هوش مصنوعی، یادگیری ماشینی و پایگاه های داده است. هدف از این کار تبدیل داده های خام به اطلاعات تجاری قابل فهم است که ممکن است شامل شناسایی گروه های رکورد داده (تحلیل خوشه ای) یا شناسایی ناهنجاری ها و وابستگی های بین گروه های داده باشد. مواردی ار قبیل، شناسایی ناهنجاری ها، یادگیری عادت های متداول، خوشه بندی، طبقه بندی و … را می توان بعنوان پروژه های اصلی در حوزه داده کاوی دانست.

داشبوردهای مدیریتی و تعاملی:

نتایج تحلیل داده ها از روش های مختلف، اغلب بعنوان سامانه های داشبوردهای مدیریتی تعاملی، در دسترس مدسران و کارشناسان سازمانها قرار می گیرد. این داشبوردها، بر اساس KPI ها، گزارشات مهم و لحظه ای در سه سطح استراتژیک, تاکتیکی و عملیاتی ایجاد می شوند. در داشبورد ها، هدف پایش عملکردها، مانیتورینک سلامت عملکردی و پایداری خدمات می باشد.

پلتفرم رویکردهای تحلیلی یکپارچه

1400/03/26 در مقاله /توسط محمدرضا معبودیانرویکرد تحلیلی یا پلتفرم یکپارچه یا Integrated Analytics Platform، مفهوم جدیدی در محدوده سامانه های BI می باشد.سامانه های «رویکردهای تحلیلی یکپارچه»، برای تلفیق بینش ها و دانش های داده محور، در گردش کار و برنامه های روزمره سازمان، بکار برده می شوند. تا بتوانند به اپراتورها، تکنیسین ها، کارشناسان، و حتی مشتریان کسب و کارها، در تصمیم گیری ها کمک نمایند.

رویکرد تحلیلی با پلتفرم یکپارچه به چه معناست؟

یک پلتفرم یکپارچه رویکردهای تحلیلی، یک راهکار End-to-End برای تحویل دهی و اشتراک گذاری بینش ها و تحلیل های هوش تجاری (Business Intelligence) از چندین منبع می باشد.

اینگونه پلتفرم ها، امکان تجسم و بصری سازی داده ها و ارائه خدماتی مانند پیش بینی درآمد، پیش بینی روند و ارزیابی استراتژی ها را میسر می کنند.

سازمان های داده محور، با تجمیع Analytics های کسب و کار، در یک پلتفرم یکپارچه رویکردهای تحلیلی، بستر هوشمند سازی و خودکار سازی را فراهم می سازند.

این پلتفرم ها، با ایجاد برنامه های کاربردی جدید مبتنی بر دانش ها و بینش های سازمانی می باشند.

این پلتفرم ها در لایه UI و چرخه های فرآیندی هوشمند در لایه Work Flow ها، سعی در ایجاد AI Driven Decision Making در سازمانها دارند. در اینجاست که عبارتهایی همچون Embedded Analytics به گوش می رسند و برنامه های کاربردی به هوش مصنوعی و علم داده، تجهیز می شوند.

رویکرد تحلیلی و مزایا و اهمیت پلتفرم یکپارچه رویکردهای تحلیلی

پلتفرم های یکپارچه رویکردهای تحلیلی، با تمرکز به چسبندگی بر شاخص های کلیدی عملکرد در هر حوزه و فرآیندبر:

- درآمد زایی

- بهره وری

- افزایش رضایتمندی

متمرکز هستند. همچنین اینگونه پلتفرم ها، باعث افزایش میزان سازگاری معیارها و سنجه های شاخص ها، در میان همه فرآیندها شده است.

در واقع دسترسی پذیری ها و به اشتراک گذاری ها، را تسهیل می کنند. برای اینکار، برنامه های کاربردی، با دریافت سرویس های داده محور از اینگونه پلتفرم ها، محیط های کاربری خود را تقویت می کنند.

با اینکار UI های غنی سازی شده با تحلیل های داده و منطبق بر اهداف سازمانی در دسترس قرار می گیرند. همچنین با غنی سازی موتورهای گردش فرآیند به AI، و با استفاده از یادگیری ماشین، لایه مدیریت گسترش پیدا کرده و همکاری های تیمی تقویت می شود. در نتیجه کیفیت تصمیم گیری ها و اقدامات هوشمند ارتقاء یافته و تعالی سازمان هدفگیری می شود.

غنی سازی تحلیل داده ها

پلتفرم های یکپارچه رویکردهای تحلیلی، فقط از داده های ساختیافته و سازمانی استفاده نمی کنند. بلکه از داده های شبکه های اجتماعی و سایر داده های NoSQL، شامل:

- متن ها

- تصاویر

- فیلم ها

- اصوات

جهت غنی سازی تحلیل ها بهره می برند. الگوریتم های مختلف متن کاوی، بینایی ماشین، پردازش گفتار در اینگونه پلتفرم ها، جایگاه ویژه ای دارند.

چرا Integrated Analytics Platform ها برای بقا و رقابت پذیری لازم هستند؟

شاید همه تصور می کنند که در دسترس نبودن داده، بزرگترین چالش تصمیم گیری است، اما اینگونه نیست. بزرگترین چالش تصمیم گیری، ترکیب داده های مرتبط با توجه به شرایط مسئله و یکپارچه سازی داده ها می باشد. در واقع، نبود یک بستر تکنولوژیک و جامع برای تجمیع و تلفیق داده ها و تحلیل ها، بزرگترین چالش تصمیم سازی و تصمیم گیری داده محور می باشد. با پلتفرم های یکپارچه Analytics می توان به:

- شناسایی فرصت ها

- بهبود ارتباطات

- حذف نقاط کور

- موارد راهبردی

این چنینی تمرکز کرد و فرایندهای کاری و عملیات های جاری را برای بقا و رقابت سازمانی تجهیز کرد.

داده کاوی و رویکردهای تحلیلی

1400/03/26 در مقاله /توسط محمدرضا معبودیانداده کاوی می تواند منجر به استقرار انواع سیستم های رویکردهای تحلیلی (Analytics) شود. هنگامی که نیازمند استفاده از تحلیل داده ها و داده کاوی در فرآیندهای تصمیم گیری روزمره ی سازمانی باشیم، انواع مختلفی از سیستم های رویکرد تحلیلی قابل تصور خواهند بود. در این نوشته برآنیم تا انواع سامانه های رویکرد تحلیلی را تشریح کرده و دید جامعی را در این محدوده، ترسیم نماییم.

در ابتدا مناسب است که به انواع سیستم های ارائه دهنده رویکردهای تحلیلی، اشاره ای داشته باشیم:

- سیستم داشبوردهای تعاملی

- سیستم های هشداردهی(Alerting)

- سیستم های تحلیلی اگر آنگاه (What -if)

- سیستم های تخمین گر(Estimation)

- سیستم های پیش کننده (Prediction)

- سیستم توصیه گر (Recommendation)

- سیستم های محاسبات هوشمند و پویا (Dynamic Calculation)

و…

با استفاده از داده کاوی و رویکردهای تحلیلی(Analytics)، داده محوری و بهره گیری از بینش های عملیاتی، محقق می شوند. سامانه های داده محور و ارائه دهنده رویکردهای تحلیلی، با توجه به نحوه تعبیه، تجمیع و ارائه خدمات تحلیلی، به دو دسته اصلی: مستقل(Stand-Alone Analytics) و جاسازی شده (Embedded Analytics) تقسیم می شوند. که البته دسته Embedded Analytics، خود به سه نوع نوع مختلف زیر تقسیم می شوند:

- سامانه های رویکرد تحلیلی متصل به دروازه (Gateway to Analytics)

- سامانه های رویکرد تحلیلی برخط (Inline Analytics)

- سامانه های رویکرد تحلیلی تزریقی (Infused Analytics)

داده کاوی و رویکردهای تحلیلی:

انواع سامانه های ارائه دهنده؛

سامانه های رویکردهای تحلیلی مستقل (Stand-Alone Analytics)

این نوع سامانه های رویکردهای تحلیلی، بیشتر در قالب داشبوردهای تعاملی مستقل (سامانه های BI مستقل) پیاده سازی می شوند. هدف از این نوع سامانه ها، افزایش قابلیت مشاهده گری (Observability) فرآیندهای سازمان، مانیتورینگ عملیات ها و دارایی ها، و همچنین راهبری آسان اپراتور ها در عملیات ها می باشد. نتیجه اینگونه رویکردهای تحلیلی، اطلاع رسانی، افزایش آگاهی ها و طبیعتاً آسان سازی و روان سازی عملیات های اپراتورها خواهد بود.

سامانه های رویکردهای تحلیلی متصل به دروازه (Gateway to Analytics)

این نوع سامانه های Analytics، با استفاده از SSO (Single Sign-On) به سامانه های عملیاتی سازمان، متصل می شوند. هدف اصلی اینگونه سامانه ها، غنی سازی فرآیندهای عملیاتی و تقویت سواد داده ای اپراتورهای عملیاتی سازمان می باشد. نتیجه استقرار اینگونه سامانه ها، می تواند مانیتورینگ و پایش دقیق عملکردها و کمک به افزایش بازدهی (Performance) ها باشد. امروزه نسخه های ابتدایی سامانه های AIOps(زنجیره پایداری سیستم ها) و BIZOps(زنجیره تامین ارزش)، در قالب داشبوردهای مدیریتی این پارادایم، تعریف می شوند.

سامانه های رویکردهای تحلیلی برخط (Inline Analytics)

این نوع سامانه ها، با استفاده از یک User Interface جدید، فرآیندهای عملیاتی سازمان را ارائه می دهند. بعبارتی دیگر، نسل جدید محیط های کاربری در اینگونه سامانه های تحلیلی، ارائه می شوند. در اینگونه سیستم ها، نتایج تحلیل ها، دانش ها و بینش های مبتنی بر هوش مصنوعی در محیط های کاربری جدید ارائه می شوند. برخی از امور AIOps و BIZOps در اینگونه سامانه های تحلیلی، نقش آفرینی می کنند.

سامانه های رویکردهای تحلیلی تزریقی (Infused Analytics)

این نوع سامانه های تحلیلی، بالغ ترین و داده محور ترین سطح Analytics ها را شامل می شوند. اینگونه سامانه ها، لایه WorkFlow ها را، با استفاده از تحلیل ها، بینش ها و دانش ها پیاده سازی می کنند. پلتفرم های AIOps و BIZOps در اینجا نقش آفرینی کرده و هوشمندی عملیات را تا سر حد پایداری شاخص ها، تضمین می کنند.

وبینار داده کاوی برای مدیران

1400/03/26 در پویش ها, وبینار /توسط محمدرضا معبودیان

وبینار داده کاوی برای مدیران

- موضوعات

- متدلوژی حل مسائل داده کاوی

- انواع رویکرد های تحلیلی

- یادگیری ماشین و یادگیری آماری

- انواع پروژه های داده کاوی

- بینش ها (Insights) و رویکرد های تحلیلی خودکار

AIOps – مقدمات

1400/03/19 در مقاله /توسط محمدرضا معبودیانAIOps معادل AI for IT operations می باشد که به عنوان نسل بعدی DevOps شناخته شده است. پلتفرم هوشمند سازی در لایه هوش مصنوعی برای استفاده از فناوری های یادگیری ماشین و کلان داده در بهبود عملیاتIT می باشد.

بعبارتی دقیق تر، AIOps(زنجیره پایداری سیستم ها) تغییر الگوی در ITOps است. برای پاسخ دهی به مسائل و چالش های ITOps، از AI و يادگیری ماشین استفاده میشود. در واقع از طریق تجزیه و تحلیل، یادگیری ماشین و یادگیری عمیق، عملیات IT را در زمان واقعی، خودکار و تقویت میکند.

نتیجه مطلوب پلتفرم های AIOps

- قابلیت مشاهده گری (Full-stack Observability)

- بینش های عملی(Actionable Insights)

- اتوماسیون هوشمند(Intelligent Automation)

- چابکی دیجیتال(Digital Agility) در سازمان

اهداف اصلی AIOps چیست؟

- به کارگیری هوش مصنوعی در جهت افزایش سرعت

- چالاکی و دقت در تشخیص ناهنجاری(Anomaly Detection)ها

- پیش بینی ضعف کارآیی سیستم

- طرح پیشنهادات و توصیه ها جهت بهینه سازی عملکرد

- رفع اشکال از طریق ایجاد همبستگی میان پلتفرم های مختلف

- تحلیل و یافتن ریشه اصلی وقوع مشکلات و در صورت امکان، حل خودکار مسئله

هوشمندسازی عملیات IT به کدام نیاز پاسخ می دهد؟

با ظهور فناوری ها و افق (Trend)های جدید در دنیای دیجیتال مانند رایانش ابری، اینترنت اشیا، تحول دیجیتال، و رایانش لبه(Edge Computing)، ابعاد و پیچیدگی سیستم های کامپیوتری به شکل تصاعدی افزایش یافته است. این پیشرفت ها نیز مشکلاتی را در کار توسعه نرم افزار و عیب یابی آن به صورت سنتی، به همراه داشته است. این نیازمندی سبب پیدایش پلتفرم های AIOps شده تا بدین وسیله بتوان عملکرد تیم DevOps را تقویت کند.

از مزیت های این پلتفرم میتوان به بهبود فرآیند تولید نرم افزار اشاره کرد. این رویکرد به تیم DevOps کمک میکند تا منشاء اصلی خطا و یا ضعف عملکرد پروژه را شناسایی کند.

فرآیندها در پلتفرمAIOps

فرآیندها در پلتفرمAIOps، به صورت چرخه ای از فعالیت های مختلف، شامل پایش سیستم ها، مدیریت سیستم ها و خودکارسازی عملیات ها، تعریف می شوند. این فرآیند ها با محوریت تحلیل کلان داده و الگوریتم های یادگیری ماشین، مدیریت می شوند. در اینگونه پلتفرم ها، منابع داده ای(Data Sources)، پایه و اساس تصمیم گیری ها و داده محوری را در AIOps تشکیل می دهند.

منابع داده ای، باید با پردازش بلادرنگ و جریانی داده ها، استخراج و استنتاج شوند. این بانک های اطلاعاتی در یک انبار داده یا دریاچه داده يا پلتفرم ذخیره سازی داده ها، تجمیع میشوند. در لایه های بعدی با استفاده از الگوریتم های یادگیری ماشین و هوش مصنوعی، الگوهای رفتاری داده های مرتبط با مشکلات احتمالی، مدلسازی شده است. الگوریتم های مذکور جهت تحلیل های تشخیصی(Diagnostic)، پیش بینی(Predictive) و تجویزی(prescriptive) مورد استفاده قرار میگیرند.

در این راستا باید همواره از الگوریتم های مبتنی بر حوزه (Domain) که برای هر حوزه و صنعت به صورت خاص-منظوره تعریف می شوند، بهره برداری شود. این فرآیند ها بصورت کارا، ناهنجاری ها، ضعف های کارایی سیستم ها، بهینه سازی های عملکردی و Performance ها، و رفع اشکالات و خطاها، بصورت جامع و هوشمند مدیریت شوند. در بالاترین لایه از AIOps به خودکارسازی و هوشمندی در فرآیندها(Intelligent Automation) پرداخته شده و بهره وری، تقویت خواهد شد.

بکارگیری پلتفرم AIOps

بکارگیری پلتفرم AIOps در هوشمندسازی عملیات IT سازمان ها، امری غیرضروری و حتی رویاپردازانه بنظر میرسد. اما با توجه به فناوری های به کار گرفته شده در اینگونه پلتفرم ها امکان پذیر خواهد بود. سازمان ها باید موقعیت خود را در این مسیر ارزیابی نمایند تا برای تحقق تحول دیجیتال و تحول در نظام داده ای سازمان میزان آمادگی خود را بالا ببرند. همچنبن سیستم های IT خود را از قبیل شبکه، Cloud، سرور ها و منابع آنها، بصورت هوشمند مدیریت و ساماندهی کنند.

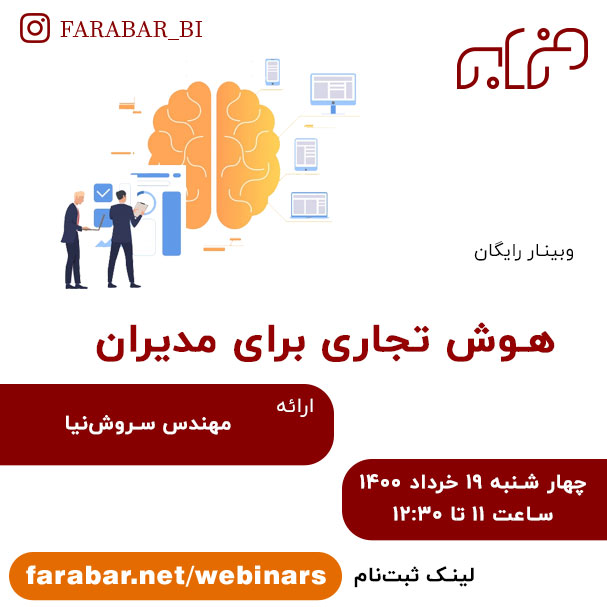

وبینار هوش تجاری برای مدیران

1400/03/19 در پویش ها, وبینار /توسط محمدرضا معبودیان

وبینار هوش تجاری برای مدیران

- موضوعات

- تعریف مفاهیم هوش تجاری

- مدیریت کیفیت داده ها

- انبارداده و فرآیندهای ETL

- بصری سازی داده ها و داشبورد های مدیریتی

- داده کاوی به عنوان مرحله بعدی BI

- رویکرد های تحلیلی سازمانی

BizOps چیست؟

1400/03/15 در مقاله /توسط محمدرضا معبودیانقبل از تعریف BizOps و هنگامی که از هوش مصنوعی سخن به میان می آید:

- بینایی ماشین

- پردازش متن

- چت بات ها

- تبدیل صوت به متن

- خودروهای خودران

و … در ذهن ها تداعی می شوند.امروز عباراتی همچون AIOps(زنجیره پایداری سیستم ها) و BizOps(زنجیره تامین ارزش) بسیار کاربرد پیدا کرده است.در حوزه بهره وری و بهبود فرآیندهای کسب و کار(Business) و ایجاد ارزش های داده محور در سازمانها، می توان از هوش مصنوعی بهره های شایانی گرفت.امروزه این پارادایم، به یکی از مفاهیم پایه ای در تحول دیجیتال و داده محوری تبدیل شده اند.

BizOps چیست؟

در یک نگاه کلان، BizOps یك رهیافت «پشتیبان تصمیم گیری» است.

براین اساس BizOps، یک رویکرد جدید در تصمیم گیری مبتنی بر داده است که «اقدامات کسب و کار» و «اقدامات فناوری» را به یکدیگر متصل می کند تا نتایج کسب و کار را هدایت کند.همچنین BizOps بر تغییر نحوه همکاری:

- تیم کاری

- تجمیع داده ها

- تجزیه و تحلیل

- گزارش دهی

به طور اساسی متمرکز است.

به عنوان یک تعریف جامع، BizOps يک رهیافت جدید در تحول دیجیتال است که از اتصال نتایج کسب و کار (Business)ها به سیستم های IT سازمان محقق می شود. این اتصال نتایج کسب و کار به بازده سیستم های IT، از ترکیب قدرت هوش مصنوعی و قدرت شهود انسان برای اتخاد تصمیم های بهتر، بهره می برد.در واقع این رهیافت منجر به تغییر رفتارِ داده محور در سازمان و در نتیجه بهبود در عملیات (Operation) ها می شود.در این پارادایم، افراد و تیم ها، با اهداف متعالی تری، هدایت می شوند.در انتها، تعاملات بهتر، کارایی بالاتر، شفافیت و اعتماد سازی قوی تر، نهادینه می شود.

به بیانی دقیق تر، این رهیافت، با ترکیب:

- نتایج کسب و کار(Business Outcomes)

- ابتکارهای فناوری (Technology Initiatives)

- هوش مصنوعی(Artificial Intelligence)

- یادگیری ماشین(Machine Learning)

- اتوماسیون هوشمند(Intelligent Automation)

داده ها را به اقدامات مبتنی بر دانش (Actionable Insight) تبدیل می کند.

رهیافت بهبود فرآیندهای کسب و کار با هوش مصنوعی یکی از ارکان اصلیِ مقیاس پذیری خدمات و محصولات سازمانها در دوران و عصر حاضر می باشد.

سازمان، برای استفاده از هوش مصنوعی برای تقویت عملیات تجاری در کسب و کارها، نیازمند الگوریتم های هوشمندِ تعبیه شده در برخی از مراحل برنامه های کاربردی می باشد. با این روش از فرآیندهای تکراری یا فرموله در تصمیم سازی و تصمیم گیری های سازمانی (بجای انسان)، پشتیبانی می شود. اینگونه برنامه های قدرتمند شده با AI، (که موجب ایجاد ارزش های جدید در سازمان می شوند) دارای پنج قابلیت هستند:

- صلاحیت علم داده(data science competence)

- مهارت دامنه تجاری(business domain proficiency)

- تخصص معماری سازمانی(business domain proficiency)

- ستون فقرات IT عملیاتی(operational IT backbone)

- کنجکاوی دیجیتال (digital inquisitiveness)

با ترکیب این پنج قابلیت، می توان به نقش آفرینی هوش مصنوعی در فرآیندهای کسب و کار، امیدوار بود.

در اکثر سازمانها، واحدهای مختلف کسب و کار، کمترین ارتباط هوشمند با واحد IT دارند و برای افزایش بهره وری و کارایی و اثربخشی، بصورت خودمختار عمل می کنند. در صورتی که با BizOps می توان به:

- افزایش شفافیت

- قابلیت مشاهده همه رخدادهای کسب و کار

- همکاری بین تیمی

- حمایت از ابداعات و نوآوری های سازمانی

دست یافت.همچنین با BizOps می توان برای مدیریت بحرانها، بهترین رهیافت ها را پیش بینی و مدیریت نمود.

بعنوان جمع بندی می توان نتایج BizOps، را به صورت «تصمیم گیری مبتنی بر هوش مصنوعی»، «اتصال خروجی سیستم های IT به نتایج واحدهای کسب وکار» و «افزایش تعاملات و هدف گذاری های پویا» اعلام نمود.

ذکر این نکته در انتهای این قسمت لازم به نظر می آید که گاهاً عبارتهای AIOps و BizOps را معادل یا بجای دیگری استفاده می کنند ولی AIOps بر عملیات هوشمند سامانه های IT و BizOps بر عملیات هوشمند کسب و کار و تجارت (Business Operations)متمرکز هستند.

نقش آفرینی BizOps بعنوان یک سیستم پشتیبان تصمیم بر پایه AI

از آنجایی که تیم های BizOps دسترسی نامحدودی به داده های همه واحدهای کسب و کار از طریق دسترسی به انبار داده، دریاچه داده و پلتفرم داده ها دارند، قادر به انجام تجزیه و تحلیل کمی و کیفی هستند.از یافته های خود برای ایجاد مکانیسم های پشتیبانی تصمیم استفاده می کنند که به آنها امکان می دهد عملیات روزمره را با ارائه رویکردهای تحلیلی (Analytics)، بصورت خودکار و هوشمندانه بهینه سازی بکنند. از سوی دیگر با سوآدوری، کاهش هزینه، افزایش درآمد و افزایش رضایت مندی را تسهیل می نماید.

اگر سیستم های BI را با هدف اتخاد تصمیم های با کیفیت، و سیستم های AI را برای اتخاد تصمیم های سریع و هوشمند، تعریف شوند، گروه BizOps، بصورت چابک، استراتژی ها و عملیات ها را همراستا می نماید.در واقع با BizOps اهداف بلند پروازانه در قالب KPI و KRI پایش مستمر شده و با استفاده از AI، تصمیم سازی های هوشمندانه برای کسب نتایج بهتر، حاصل می شود.

همکاری سامانه MDM و ESB

1400/03/12 در مقاله /توسط محمدرضا معبودیان

امروزه سامانه MDM و Data Governance به یکی از اولویتهای اصلی سازمانهای داده محور تبدیل شده است. در گذشته، ارائه دهندگان سرویس های «ETL و انبار داده» و «ESB»، بیشتر بر ادغام و تجمیع و تلفیق داده متمرکز بودند. ارتباطات Point to Point از اهمیت زیادی برخوردار بود. اکنون با فناوری های تازه به دست آمده، سامانه MDM را به عنوان یکی از اجزای اصلی گسترش پلتفرم داده ها جانمایی نموده اند.

در این نوع معماری برای پلتفرم داده ها، از Master Data ها بعنوان اجزای مهم و اساسی پلتفرم داده استفاده می شود.همچنین از سرویس های ESB و ETLها یا ابزار یکپارچه کردن انوع برنامه های کاربردی استفاده می شود. این بدان معنی است که تعاملات و ارتباطات بین اجزای مختلف پلتفرم داده ها، با همکاری قسمت سامانه MDM مدیریت و ساماندهی می شود.

داده های پایه و اصلی (Master Data) و سایر داده

داده های پایه و اصلی (Master Dataها)، موجودیت های اطلاعاتی(Entity) خود ایستا، اساسی و مستقلی هستند. در پلتفرم داده، ارتباطات و تعاملات حول محوریت آنها انجام شده است. هدف اصلی از تشکیل پلتفرم داده، تحلیل آنها می باشد. همچنین شرایط و رفتارها و پیش بینی های آنها را در سامانه MDM تعیین میکند. بعنوان مثال داده های پایه و اصلی (Master Data) را می توان شامل:

- مشتریان

- فروشندگان

- نمایندگان

- محصولات

- خدمات

- تجهیزات

- مواد اولیه و …

اعلام کرد. کسب و کار روزانه و بصورت تنگاتنگ با آنها در حال تعامل و کنشگری می باشد. به عبارتی دیگر، تراکنش های اطلاعاتی، مالی، فرآیندی و تحلیلی با محوریت این Master Data ها ایجاد شد. همچنین ذخیره سازی و چالش های داده محور و هوش مصنوعی محور، حول پاسخگویی می گردد.

ارتباط داده های پایه و اصلی

معمولاً ESB ها، بدون هیچ گونه پردازش منطقی داده ها، بصورت Stateless، تضمین مسیریابی و خدمات تحویل را ارائه می دهند. پلتفرم های داده از ESB ها برای تعاملات و ارتباطات مبتنی بر سرویس گرایی استفاده می کند عملاً سامانه ESB (ابزار یکپارچه کردن انواع برنامه های کاربردی) را به قسمت MDM مرتبط کرده و سرویس های ESB بر پایه MDM انجام می دهد.

در این طراحی، در هنگام scale شدن خدمات داده ای در پلتفرم داده، راهبری و مدیریت سرویس های جدید و یا مدیریت تغییرات در سامانه ESB، تسهیل می شود. همچنین یکپارچگی داده ها و ارتباطات تضمین می گردد. در این نوع معماری، انبار داده ها و فرآیندهای ETL نیز بر پایه Master Data عملیات های انبارش داده ها را انجام می دهد. عملا داده های تاریخچه ای را Persist می نمایند.

در آخر، برای مدیریت و حکمرانی صحیح داده ها، باید مدیریت کیفیت داده، مدیریت متادیتا و کلاً Master Data، در تعامل موثر با سامانه MDM و ESB تعریف شود. قطعا محرک تصمیم سازی های داده محور و خلق ارزش های جدید در سازمان ایجاد می شود.

وبینار داستان پردازی با داده برای مدیران

1400/03/12 در پویش ها, وبینار /توسط محمدرضا معبودیان

وبینار داستان پردازی با داده برای مدیران

- موضوعات

- داستان پردازی داده ها و بصری سازی داده ها

- سواد داده و Data Storytelling

- تمرکز بر انگیزش احساسات و تحلیل های منطقی در داستان پردازی داده ها

- راهکار های انتقال بینش ها (Insights) جهت تصمیم گیری و اقدام

- المان های داستان پردازی با داده

َAIOps و کاربردهای آن

1400/03/10 در مقاله /توسط محمدرضا معبودیانAIOps و کاربردهای آن می تواند استفاده از هوش مصنوعی در عملیات های IT ، مرتبط با کسب و کار باشد.AIOps(زنجیره پایداری سیستم ها) یا خودکارسازی پلتفرم داده، یک عملیات هوشمند است.

این امر برای نظارت و مدیریت در محیطهای مدرن فناوری اطلاعاتی شامل:

- محیط های ترکیبی(hybrid)

- پویا(dynamic)

- توزیع شده(distributed)

- ترکیب شده(componentized)

ضروری شده است.

AIOps و کاربردهای آن:

AIOps از طریق الگوریتم های هوش مصنوعی، به عملیاتهای مرتبط به سرویس های IT و DevOps کمک می کند.

AIOps سریعتر و هوشمندانه تر، مشکلات و چالش های خدمات دیجیتال را شناسایی و حل نمایند.

AIOps، با استفاده از تیم های عملیاتی در قسمت های مختلف، پیچیدگی و حجم بسیار زیاد داده های تولید شده در اکوسیستم کسب و کار را تعدیل میکنند.این مهم از بروز فاجعه ها و یا بحران های عملیاتی جلوگیری می نماید.

AIOps با خودکارسازی پلتفرم داده، میتوان مشکلات سیستمی را پیش بینی و هشدار دهی نمایند.همچنین، مدیریت زمان و اطمینان از ارائه مداوم خدمات را در هنگام Scale شدن خدمات و محصولات در کسب و کار، مدیریت نمایند.

شاید بتوان AIOps را بعنوان یکی از عوامل تاثیر گذار در تحول دیجیتال سازمانها و کسب و کارها، معرفی نمود.

اینگونه پلتفرم ها، بعنوان یک AI-powered recommendation system به سازمانها اجازه می دهد با سرعتی که در تجارت مدرن به آن نیاز دارند، مسائل ناشناخته در عملیات ها را درک و مدیریت کنند.

AIOps و کاربردهای آن را می توان در:

- قابلیت مشاهده و یا پیش بینی شرایط بحرانی(Critical Situation)

- فاجعه بار(Disaster)

- «کنترل کاهش بهره وری عملیاتی»

- شناسایی همبستگی در رویدادهای مشابه

جهت کاهش هشدار(Alarm)های سیستمی در یک محیط یکپارچه، تعریف نمود. زیربنای سیستم های AIOps را می توان علم داده، یادگیری ماشین و یادگیری عمیق دانست که خدمات هوشمندسازی را در حوزه های:

- انتخاب داده(Data Selection)

- کشف الگو(Pattern discovery)

- استنباط(Inference)

- همکاری(Collaboration)

- اتوماسیون(Automation)

پشتیبانی می کنند.

AIOps و کاربردهای آن در داشبوردهای مدیریتی:

بسیاری از سازمانها و کسب و کارها، در اولین اقدام برای پیاده سازی سیستم های AIOps، اقدام به طراحی داشبوردهایی برای واحدهای مختلف عملیاتی خود می کنند.

بدین وسیله کارشناسان با مشاهده داشبوردها، موارد بحرانی يا چالش ها را شناسایی و اقدامات متناظر را انجام می دهند.

در گامهای تکمیلی در اینگونه سناریوها، با استفاده از الگوریتم های داده کاوی، سعی در پیش بینی:

- موارد بحرانی (Disaster Prediction)

- تخصیص منابع

- عملیات های خاص

برای رخدادهای آتی، می کنند. اینگونه رهیافتها برای سطح بلوغ میانی سازمان ها توصیه می شود.

در صورت Scale شدن خدمات و محصولات در کسب و کارها، نیاز به نگهداری و بروز رسانی فرآیندها می باشد که می تواند کیفیت خدمات را تحت الشعاع قرار دهد. برای سطوح بالاتر بلوغ داده محوری، استفاده از پلتفرم های AIOps پیشنهاد می شود که در ادامه به آن اشاره کوتاهی می شود.

AIOps در نگاه جامع:

در یک دیدگاه جامع، یک پلتفرم AIOps، در گام اول، داده های ناهمگن را از منابع مختلف ذخیره سازی می کند. این داده ها در مورد تمام اجزای محیط عملیات IT شامل (شبکه ها، برنامه ها، زیرساخت ها، نمونه های ابری، و …) می باشد.

سپس با استفاده از الگوریتم های آنتروپی، نویز و تکثیر را از بین می برد و فقط داده های کاملاً مرتبط را انتخاب می کند. این فیلتر الگوریتمی، به طور گسترده تعداد هشدارهایی را که تیم های عملیات باید با آن روبرو شوند کاهش می دهد و تکرار کارها، را از بین می برد.

در عین حال، پلتفرم AIOps، با استفاده از الگوریتم های یادگیری ماشین و یادگیری عمیق، اقدام به گروه بندی و ارتباط دهی رخداده ها و مسائل می کند. در مرحله بعدی، الگوهای موجود در داده ها و رخدادها را کشف و نتایج تجزیه و تحلیل را به یک محیط همکاری قابل اشتراک می کند.

نتیجه اینگونه پلتفرم ها، دستیابی به گردش کار با کمترین دخالت انسان و در نهایت بهینه سازی اتوماسیون ها خواهد شد. در انتها، پلتفرم AIOps دلایل و راه حل های مربوط به هر حادثه را ذخیره می کند.

همچنین از این دانش برای کمک به تیم های عملیاتی، در تشخیص علل و تجویز راه حل های آتی استفاده خواهد شد. بعنوان نمونه ای از پلتفرم های مطرح در حوزه AIOps می توان به Dynatrace ، LogicMonitor و Moogsoft اشاره نمود.

آدرس: تهران، خیابان خرمشهر (آپادانا)، خیابان قنبرزاده، کوچه چهاردهم، پلاک 22

تلفن: 88533266-021 (10 خط)

آخرین مقالات

وبکست ها و پویش ها

وبینار علم داده برای مدیران1400/08/22 - 16:36

وبینار علم داده برای مدیران موضوعات علم داده و رابطه آن با هوش تجاری و هوش مصنوعی رویکردهای تحلیلی کسب و کار مفاهیم پایه Big Data اجزای پلتفرم داده یادگیری ماشین و علم داده محاسبات شناختی ثبت نام کنید!